Optimalisasi Performa Model Bahasa Besar (LLM) melalui Fine-Tuning

Pengantar

Large Language Models (LLM) telah merevolusi berbagai bidang, mulai dari chatbot hingga analisis teks otomatis. Namun, untuk menangani tugas yang lebih spesifik, fine-tuning menjadi metode yang efektif dalam mengoptimalkan model agar sesuai dengan kebutuhan pengguna.

Apa Itu Fine-Tuning LLM?

Fine-tuning adalah proses penyesuaian model bahasa besar dengan menggunakan dataset tambahan yang lebih spesifik. Tujuan dari fine-tuning adalah meningkatkan kinerja model dalam domain tertentu tanpa harus melatih ulang model dari awal.

Mengapa Fine-Tuning Penting?

- Meningkatkan Akurasi – Model yang sudah dilatih dengan dataset umum dapat disesuaikan untuk memahami terminologi spesifik industri.

- Efisiensi Biaya dan Waktu – Daripada melatih model dari awal, fine-tuning menggunakan model yang sudah ada dan mempercepat proses adaptasi.

- Penyesuaian dengan Konteks Spesifik – Model dapat dikustomisasi agar lebih memahami gaya bahasa atau kebutuhan bisnis tertentu.

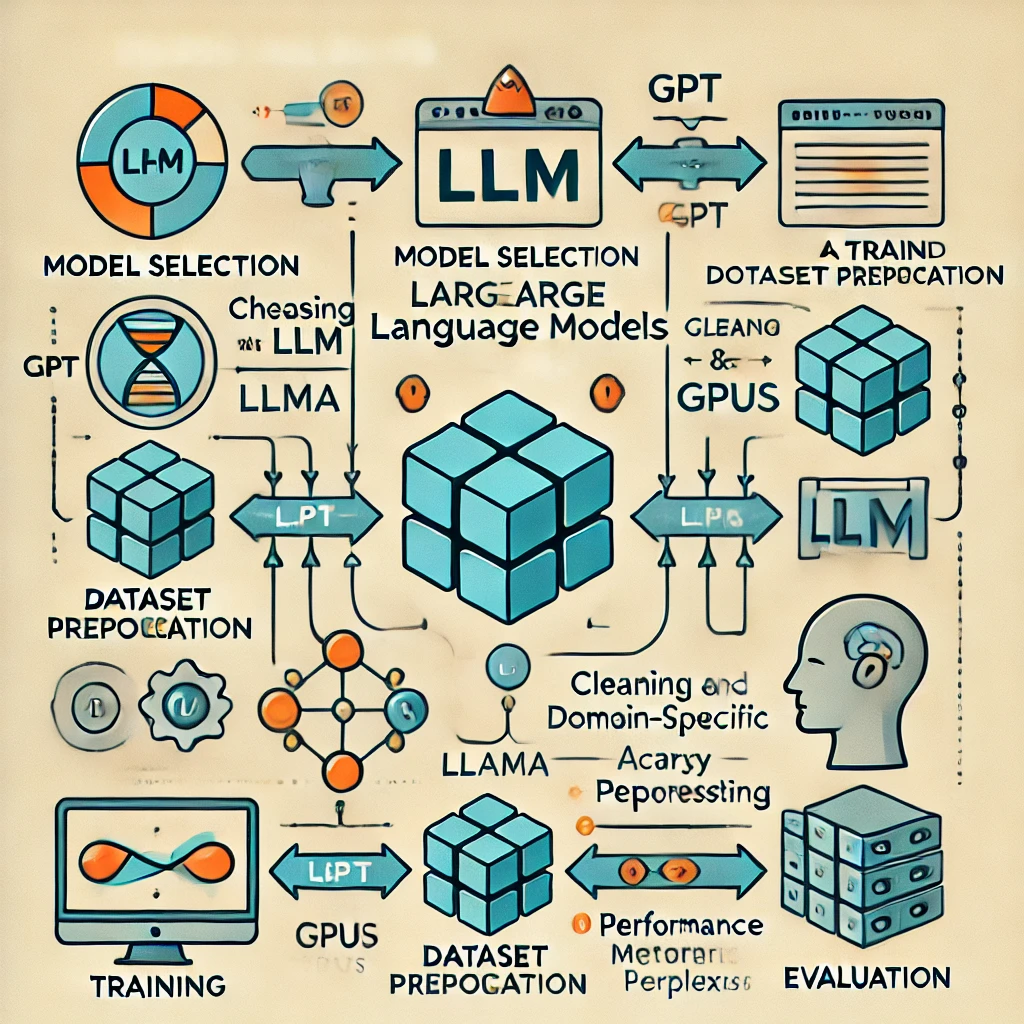

Proses Fine-Tuning LLM

Fine-tuning pada LLM umumnya melalui beberapa tahapan berikut:

1. Pemilihan Model Dasar

Sebelum melakukan fine-tuning, penting untuk memilih model dasar yang paling sesuai dengan kebutuhan, seperti GPT, LLaMA, atau Falcon.

2. Persiapan Dataset

Dataset harus sesuai dengan domain yang ditargetkan. Sumber data dapat berupa:

- Dokumen internal perusahaan

- Data pengguna dari interaksi chatbot

- Teks spesifik dari publikasi atau jurnal tertentu

3. Preprocessing Data

Sebelum digunakan dalam fine-tuning, data harus dibersihkan dan diformat agar sesuai dengan format input model. Teknik preprocessing meliputi:

- Tokenisasi

- Penghapusan noise (karakter tak perlu, duplikasi)

- Normalisasi teks

4. Konfigurasi Hyperparameter

Pengaturan hyperparameter yang tepat akan mempengaruhi hasil fine-tuning. Beberapa parameter penting yang perlu diperhatikan:

- Learning Rate: Menentukan seberapa cepat model beradaptasi dengan dataset baru

- Batch Size: Jumlah sampel yang diproses dalam satu iterasi

- Epochs: Jumlah iterasi penuh terhadap seluruh dataset

5. Pelaksanaan Fine-Tuning

Fine-tuning dapat dilakukan dengan framework seperti:

- Hugging Face Transformers – API yang menyediakan berbagai model siap pakai

- PyTorch/TensorFlow – Framework deep learning yang fleksibel untuk eksperimen fine-tuning

6. Evaluasi Model

Setelah fine-tuning, model harus diuji dengan dataset validasi untuk memastikan peningkatan performa. Metrik evaluasi yang sering digunakan meliputi:

- Perplexity (PPL): Ukuran ketidakpastian model dalam memprediksi kata berikutnya

- F1 Score: Kombinasi dari precision dan recall untuk klasifikasi

- BLEU/ROUGE Score: Mengukur kesamaan output model dengan teks referensi

Teknik Fine-Tuning yang Populer

Berbagai metode fine-tuning dapat diterapkan pada LLM tergantung pada kebutuhan:

1. Full Fine-Tuning

- Seluruh parameter model diperbarui

- Membutuhkan komputasi tinggi dan dataset besar

- Cocok untuk aplikasi khusus seperti NLP medis atau hukum

2. LoRA (Low-Rank Adaptation)

- Menambahkan lapisan adaptasi kecil di dalam model

- Mengurangi kebutuhan memori

- Ideal untuk perangkat dengan sumber daya terbatas

3. Prompt Engineering vs Fine-Tuning

- Prompt Engineering: Menyesuaikan prompt untuk mendapatkan jawaban yang lebih baik tanpa mengubah model

- Fine-Tuning: Mengubah parameter internal model agar lebih peka terhadap konteks tertentu

Tantangan dalam Fine-Tuning LLM

Meskipun fine-tuning menawarkan banyak manfaat, ada beberapa tantangan yang perlu diperhatikan:

- Kebutuhan Data Berkualitas Tinggi – Dataset yang buruk dapat menyebabkan bias atau hasil yang tidak diinginkan.

- Komputasi yang Mahal – Fine-tuning model besar membutuhkan GPU atau TPU berkinerja tinggi.

- Overfitting – Model bisa menjadi terlalu spesifik pada dataset fine-tuning dan kurang mampu menangani variasi baru.

Kesimpulan

Fine-tuning LLM adalah teknik yang sangat berguna dalam menyesuaikan model bahasa besar agar lebih relevan dalam domain tertentu. Dengan pemilihan dataset yang tepat, metode fine-tuning yang sesuai, dan evaluasi yang mendalam, performa model dapat ditingkatkan secara signifikan tanpa harus melatih ulang dari awal.